-Project:

-Project:

Improvement of Teaching Through

Scientific self-Evaluation

Letzte Änderung: 28.8.2021

Konzeption & Projektleitung:

apl. Prof. em. Dr. Georg Lind

Programmierung:

Georg Lind

Mohammed Elghitany

(Kristian Scholz)

![]() Instruktion für Dozenten

Instruktion für Dozenten

![]() Was bedeutet wissenschaftliche Evaluation?

Was bedeutet wissenschaftliche Evaluation?

![]() Wie es dazu kam...

Wie es dazu kam...

![]() Kriterien wissenschaftlicher Evaluation

Kriterien wissenschaftlicher Evaluation

![]() Vorteile auf einen Blick

Vorteile auf einen Blick

![]() Warum Selbstevaluation?

Warum Selbstevaluation?

![]() Ein Beitrag zur Verbesserung der Lehre

Ein Beitrag zur Verbesserung der Lehre

![]() Angebot zur Unterstützung

Angebot zur Unterstützung

![]() Das ITSE-Sigel

Das ITSE-Sigel

![]() Das Grundmodell der Selbstevaluation

Das Grundmodell der Selbstevaluation

![]() Vorarbeiten

Vorarbeiten

![]() Instruktionen für Dozenten

Instruktionen für Dozenten

![]() Beispielfragebogen

Beispielfragebogen

![]() Farbcodierung des Fragebogens

Farbcodierung des Fragebogens

![]() Evaluation von Lehre und Bildungspolitik

Evaluation von Lehre und Bildungspolitik

![]() Datenschutz

Datenschutz

![]() Literaturnachweise

Literaturnachweise

"Our schools must preserve and

nurture the yearning for learning

that everyone is born with."

W. Edward Deming,

Professor für Management am MIT, Cambridge, 1994, S. 145

"The more any quantitative social indicator is used for social decision-making, the more subject it will be to corruption pressures and the more apt it will be to distort and corrupt the social processes it is intended to monitor.".

Campbell, D.T..

Assessing the Impact of Planned Social Change. Paper #8 Occasional Paper Series. (1976) ... more*

Einleitung zur neuen Auflage von 2010 (neue Texte in kursiv)

Donald T. Campbell's (1976) hatte vorhergesagt, dass jede Evaluation, von der eine materielle Belohnung oder Bestrafung abhängt, früher oder später notwendigerweise korrumpiert, also als Basis der Qualitätskontrolle und -entwicklung invalide und wertlos wird. Alle Beteiligten wollen Strafen vermeiden und Belohnungen ergattern und wenn dies aufgrund fehlender Resourcen oder Können nicht möglich oder zu teuer ist, greift man eben zu mehr oder weniger kriminellen "Tricks", um den gewünschten Erfolg zu erreichen. Damit kehrt sich aber die Intention, mit Hilfe von Tests und Evaluation Leistungssteigerungen zu stimulieren oder gar zu erzwingen, in ihr Gegenteil. Fremdevaluation führt dann trotz großem Mitteleinsatz (der teilweise fehlt, um die Qualität zu verbessern) zu einer Stagnation oder gar zu einem Rückgang der gewünschten Schulleistungen. Inzwischen wurde diese Vorhersage durch Bildungstests wie PISA so eindrucksvoll bestätigt, dass wir heute geneigt sind, von "Campbell's Law" zu sprechen (vgl. Amrein & Berliner, 2002; Lind, 2009b).

Gleichwohl heißt dies nicht, dass Evaluation und Tests immer nutzlos oder kontraproduktiv sind. Im Gegenteil, sie können sehr wertvolle Dienste für die Steigerung der Leisrungsmotivation und der Leistungen tun. Dazu muss man allerdings das falsche Menschenbild korrigieren, das hinter der strafbewehrten Fremdevaluation (high stakes testing) steht. Dieses negative Menschenbild geht grundsätzlich davon aus, dass Menschen lern- und leistungsunvillig sind und des äußeren Drucks (oder Zugs) bedürfen, um etwas (gut) zu tun. Dadurch, dass chronische Fremdevaluation zu einer Verringerung der individuellen Verantworung für die eigene Lern- und Leistungsfähigkeit führt, entsteht eine selbsterfüllende Prophezeiung: Wer die eigene Verantwortung an äußere Steuerungsmächte abgegeben hat, hat tatsächlich kaum noch Eigenmotivation und wird daher von Außendruck abhängig (Deci et al. 1999; Kohn, 1999; Frey & Osterloh, 2008; Osterloh & Weibel, 2006). Die Forschung zeigt jedoch, dass Menschen von Geburt an neugieig, lernfähig und leistungsbereit sind und dies auch bleiben, wenn man diese Anlagen nicht korrumpiert. Ich bin daher überzeugt, dass die große Mehrheit von Lehrern und Dozenten effektiv unterrichten möchte und dass geringe Fortschritte auf diesem Gebiet nicht mit ihrer Leistungsbereitschaft zu tun haben, sondern mit ihrer Ausibildung und mit dem Mangel an valider Rückmeldung über die eigenen Lehrwirksamkeit bzw. die Lehrwirksamkeit der Methoden, die man einsetzt.

An diesem letzten Punkt setzt ITSE an. ITSE liefert die Rückmeldung über die eigenen Lehrwirksamkeit (oder andere Effekte des eigenen professionellen Handelns) und regt dadurch automatisch Lernprozesse an und belohnt diese auch. Wenn man sieht, dass die eigenen Anstrengungen und Ideen Erfolg haben, wird man sie beibehalten und nach weiteren Verbesserungen streben. Wenn man durch ITSE sieht, dass sich auf Seiten kaum Lerngewinne feststellen lassen, wird man es mit anderen Methoden versuchen oder, bei chronischer Erfolglosigkeit, sich um didaktisch-psychologische Weiterbildung bemühen. Natürlich ist das nicht immer ganz einfach. Gleichzeitig muss nämlich an der Definition und Messung der Lernziele gearbeitet werden. Unklare Lernziele lassen sich nicht evaluieren. Anspruchsvolle Lernziele lassen sich nicht leicht in ein Messinstrument übersetzen. Hier sind manchmal enorme Anstrengungen notwendig, wie das Beispiel der moralischen Urteiuls- und Diskursfähigkeit zeigt ... mehr. Oft bieten sich aber auch recht einfache Lösungen an, insbesonders dort, wo bereits viele Testaufgaben vorliegen. So lässt sich ein Test für die Lehrwirksamkeit im Fach Mathematik leicht dadurch erstellen, dass man markante Aufgaben aus Klassenarbeiten über eine längeren Zeitraum auswählt und daraus einen kurzen Evaluationstest zusammenstellt.

Was bedeutet selbst-kontrollierte, wissenschaftliche Evaluation?

WissenschafticheEvaluation bedeutet, dass die Evaluation an wissenschaftlichen Standards orientiert (Sanders, 1994). Sie unterscheidet sich grundlegend von ad hoc-Evaluationen, die meist andere Funktionen haben. Wissenschaftliche Evaluationen dienen ausschließlich der Verbesserung von Programmen, Maßnahmen oder Methoden und nicht dazu, Personen oder Personengruppen zu belobigen und zu belohnen oder zu bestrafen. Ihr Zweck in der Lehre ist die Qualitätsverbesserung.

Gegenstand der wissenschaftlichen Evaluation sind also in erster Linie Programme, Maßnahmen und pädagogische oder andere Methoden. Sie wird daher oft auch als Programmevaluation bezeichnet. Auch wenn der Begriff Evaluation häufig für die Begutachtung und Bewertung von Personen und Personengruppen benutzt wird, handelt es sich hierbei nichtum Evaluation. Personenbeurteilungen unterliegen ganz anderen wissenschaftlichen und rechtlichen Standards und werfen andere Probleme auf.

Bei Programmevaluationen wird gewöhnlich unterschieden, wer die Evaluation veranstaltet. Wenn sie von außenstehenden Wissenschaftlern durchgeführt wird, spricht man von Fremdevaluation. Wenn der Hauptakteur (hier: der Dozent) sie selbst durchführt, sprechen wir von Selbstevaluation. Selbstevaluation hat sich als ein besonders effektiver Weg der Qualitätsverbesserung in der Lehre erwiesen, weil der zentrale Akteur (möglichst unter Heranziehen von anderen direkt Beteiligten und von Experten) selbst die Evaluation veranlasst, die Ziele festlegt, die eingesetzten Methoden auswählt oder entwickelt, die Datenauswertung festlegt oder selbst durchführt und auch die Interpretation und Bewertung der Ergebnisse selbst vornimmt, und damit in hohem Maße dafür sorgt, dass die Evaluation optimal nutzbringend ist. Der entscheidende Unterschied zur Fremdevaluation ist aber, dass sie anonym bleiben kann und daher gegen die Anfechtungen durch Korruption weitgehend geschützt ist.

Da mit dem Begriff Selbstevaluation häufig etwas anderes bezeichnet wird als was wir hier meinen, benutzen wir den genaueren Begriff selbst-kontrollierte, wissenschaftliche Evaluation. Mit dem Begriff Selbstevaluation wird oft auch eine Evaluation bezeichnet, die sich ausschließlich auf die subjektive Selbsteinschätzung des Hauptakteurs stützt. Dies ist hier nicht gemeint. Eine wissenschaftlich fundierte Evaluation kann durch Selbst- oder Fremdeinschätzungen ergänzt, aber nicht ersetzt werden. ... mehr. Auch wenn der Hauptakteur die Evaluation selbst durchführt, muss er (oder sie) nicht auf wissenschaftliche Standards verzichten. Er ist dabei nicht auf ein bestimmtes Forschungsparadigma (z.B. auf randomisierte Experimentaldesigns) festgelegt, sondern sollte möglichst die adäquateste Untersuchungsanlage wählen. Das kann auch ein Handlungsforschungsmodell oder die genaue Dokumentation von Abläufen sein (Prozessevaluation).

Im Prinzip kann man jede Fremdevaluation mit wenig Aufwand so verändern, dass sie zur Selbstevaluation wird. Bislang hat z.B. ein Kultusminister seine Schulen und Schüler testen lassen, ob sie die von außen gesetzten Standards erreichen, um auf dieser Grundlage Schulen und Schüler mit "Anreizen" zu höheren Leistungen anzuspornen (oder zu zwingen). Wir wir gesehen haben, funktioniert diese kaum oder ist meist sogar kontraproduktiv. Mit ITSE kann er dieselbe Erhebung durchführen lassen, nun aber mit dem Ziel, seine eigene Bildungspolitik zu evaluieren und seine eigene politische Wirksamkeit zu kontrollieren und ggfs. zu verbessern. Dies hat einerseits den Vorteil, dass die Evaluation viel billiger ist, weil die Stichprobe kleiner und die Tests weniger aufwändig sein können. Zum anderen hat dies den Vorteil, dass, weil ITSE anonym ist, es keinen Grund gibt, die Erhebungsdaten zu verfälschen.

Dies muss Fremdevaluation bzw. öffentliche Evaluation nicht ausschließen. Zum einen besteht die Möglichkeit, ähnlich wie beim Qualitätsmanagement nach DIN 9000x die Durchführung von Selbstevaluation und Qualitätsmanagement ohne Ansehen der Testergebnisse als Anzeichen von guter Qualität zu honorieren. Bei ITSE wird einer Lehrveranstaltung nach drei Durchführungen ein ITSE-Sigel auf Zeit verliehen, ähnlich dem DIN-Sigel. Zum anderen können die bei der Selbstevaluation anfallenden Daten anonym oder teil-anonym zusammengefasst und meta-analysiert werden, um hieraus wertvolle Hinweise für die Wirksamkeit bestimmter Faktoren zu prüfen, die sich im Einzelfall nicht darstellen lassen (Lind, 2009).

Für die selbst-kontrollierte, wissenschaftliche Evaluation der Wirksamkeit von Maßnahmen und Methoden richtet sich Lehrende und Lehrer, Fachleiter, Schulleiter, Rektoren und Bildungsadministratoren an allen Bildungsinstitutionen, aber auch an Bildungspolitiker und Manager oder leitende Beamte, die für Bildungs verantwortlich sind. ...

weiter zur Instruktion für Lehrer und Dozenten.

Wie es dazu kam...

Studierende wie auch Lehrende sind, so beobachte ich immer wieder, im Grunde hoch motiviert zu lernen, den Stoff zu lernen, den man im Studium angeboten bekommt, bzw. zu lernen, wie man den Stoff so anbietet, damit er möglichst gut gelernt werden kann. Kein Wunder, denn Lernen ist eigentlich etwas Natürliches, wie wir nicht erst seit Aufkommen der modernen Neurobiologie wissen. Das Interesse am Lernen ist jedem Menschen von Geburt an mitgegeben. Hierüber sind sich Lern-, Entwicklungs- und Motivationspsychologen einig mit den Beobachtungen des Wirtschaftswissenschaftlers Edward Deming und des Neurologen Manfred Spitzer, deren Einsichten ich als Motto für das ITSE-Projekt gewählt habe.

Woran liegt es dann, dass das Lernen und Lehren im Alltag oft nicht so gut funktioniert, wie man es sich wünscht, oder dass es manchmal sogar ausgesprochen schlecht funktioniert, wenn nicht an der Motivation zu lernen? Natürlich sind wir nicht ständig und überall bereit oder bestrebt zu lernen. Es gibt viele Dinge, die uns aktiv davon abhalten können, wie Müdigkeit, Angst oder der Wunsch nach Entspannung (obwohl viele Lernbegierige behaupten, dass gerade das Lernen auch entspannend sein kann). Aber oft ist es nicht der Mangel an Motivation (oder die Wirkung von ablenkenden Motiven), die uns vom effektiven Lernen abhält, sondern der Mangel an guten Lerntechniken und die Schwierigkeit, angemessene, zuverlässige Rückmeldung über den Erfolg (oder Misserfolg) unserer Handlungen zu bekommen, die das Lernen erschweren.

Der Mangel als Lerntechniken und an zuverlässiger Wirkungsrückmeldung ist besonders eklatant. Hochschullehrer und Lehrer unterrichten mit der Gewissheit, dass sie etwas Wichtiges lehren und dass ihre Schüler und Studenten dies alles sich merken und auch später, wenn sie es im Beruf brauchen, noch parat haben werden. Aber trifft dies überhaupt zu?

Natürlich prüfen wir in Klausuren und Tests, auf die sich die Studierende intensiv und sehr speziell vorbereiten, ob bestimmtes Begriffswissen abrufbar ist. Aber wir wissen nicht, ob es auch nur wenige Wochen danach noch vorhanden ist und ob die Studierenden es später einmal kompetent anwenden können. Vor allem wissen wir wenig darüber, ob die beobachteten Resultate auf unsere Anstrengungen in Lehre und Unterricht zurückzuführen sind. Haben die Lernenden das Meiste schon in den Unterricht mitgebracht? Hängt der Lernerfolg eher mit außerschulischen Bedingungen zusammen? Bei so viel Ungewissheit ist es am klügsten, seiner eigenen Intuition zu trauen, statt "bewährte" Lehrmethoden durch neue zu ersetzen. Der Verbesserung der Lehre hilft das aber natürlich wenig.

Kriterien wissenschaftlicher Evaluation

Evaluation ist nicht gleichzusetzen mit experimenteller Theorienprüfung, aber sie kann viel davon lernen.

Die wissenschaftliche Evaluation muss klar abgegrenzt werden gegenüber unsystematischen, vorwissenschaftlichen Fallanalysen wie auch gegenüber pseudo-wissenschaftlich angelegten Großstudien mit rigiden Standards. Beides kann keine sichere Grundlage für die Verbesserung der Lehre sein.

-

Vorwissenschaftliche Analysen lassen sich allzuleicht von der eigenen Eitelkeit einfangen. Sie sind nicht selten von dem Wunsch beseelt, das eigene Handeln als das bestmöglichste bestätigt zu bekommen. Es fehlen hier alle Sicherheitsvorkehrungen gegen Selbsttäuschung.

-

Pseudo-wissenschaftliche Analysen setzen häufig auf große Beobachtungszahlen und hochkomplexe statistische Verarbeitungsmethoden, weisen jedoch große Defizite auf hinsichtlich so grundlegender Dinge wie der Validität der Daten, der Qualität des Beobachtungsdesigns und der Aufmerksamkeit für die Frage, welche Konsequenzen aus den Beobachtungen zu ziehen sind und welche Rückwirkungen solche Konsequenzen auf das Lernverhalten der Adressaten hat.

-

Evaluation braucht allgemeine, übergreifende Standards, nach denen Vergleiche möglich sind, aber sie muss auch Konzepte wie Individualität und Subjektivität ernst nehmen. Lernerfolge müssen immer in Bezug gesetzt werden zu dem individuellen Eingangswissen, den sozialen Unterstützungssystemen und dem Lernumfeld.

Schlecht gemachte Evaluation führt meist zu falschen Empfehlungen hinsichtlich der Effizienzsteigerung der Lehre, wodurch die Lage der Hochschule nur noch verschlimmert werden würde. "So wünschenswert eine stärkere Ausrichtung der Hochschulen an Effizienzkriterien ist, so schwerwiegend können die Folgen sein, wenn die konkrete Umsetzung fehlerhaft ist", schreibt der Hochschulexperte Bernhard Nagel (2004).

Gute Programmevaluation setzt die Einhaltung bestimmter Standards voraus, die man nicht unterschreiten sollte (vgl. Lind, 2004). Gute Evaluation erfordert u.a.:

-

Eine hohe theoretische und prädiktive Validität der Beobachtungskonstrukte: Wird genau das beobachtet, was beobachtet werden soll? Steht das Beobachtete mit dem zukünftigen Verhalten der Studierenden bzw. ihre zukünftigen Kompetenzentwicklung im Beruf in einem allgemein bedeutsam gehaltenen Zusammenhang? ("Statistische Signifikanz" hat mit dieser Art von Bedeutsamkeit wenig bis gar nichts zu tun.)

-

Ein angemessenes Beobachtungs-Design, das es ermöglicht, möglichst viele konkurrierende Erklärungen für die Beobachtungsergebnisse auszuschließen und damit zu einer möglichst eindeutigen Zuschreibung der Ursächlichkeit unseres Lehrverhaltens zu gelangen. Dazu sind zwei Dinge mindestens erforderlich: a) eine zweimalige Erhebung (zum Beispiel am Anfang und am Ende eines Kurses) und b) das Vorhandensein von Vergleichsdaten von ähnlichen Studierenden und ähnlichen Zeiträumen. Eine Einmalerhebung, mag sie noch so groß sein, ist für Evaluationszwecke in der Regel ungeeignet.

-

Eine Begrenzung des Evaluationsauftrags auf die Analyse und Bewertung der Methoden, Maßnahmen und Systemmerkmalen, die es zu verbessern gilt. Mit anderen Worten: Eine Evaluation, die der Qualitätsentwicklung dient, sollte grundsätzlich nicht auf die betroffenen Personen (hier: Studierende, Dozenten) ausgedehnt und gleichzeitig zur Zertifizierung oder Benotung eingesetzt werden. Bei einer solchen Vermengung der Zwecke werden die Evaluationsergebnisse, wie man weiß, sehr unscharf und damit kaum mehr brauchbar (siehe u.a. Amrein & Berliner, 2002; Nichols & Berliner, 2005).

-

Hohe Transparenz und eine intensive Beteiligung aller davon Betroffenen in allen Phasen eines Evaluationsvorhabens, um einerseits vorhandene Evaluationskompetenz (im Sinne der Punkte 1 und 2) bestmöglichst auszuschöpfen, andererseits um auch die Voraussetzungen für die notwendige Akzeptanz und Umsetzungsmotivation zu schaffen.

Wenn eine Evaluation diese bekannten und von Evaluationsexperten geteilten Anforderungen nicht oder nur unvollständig erfüllt, kann, ja wird sie eher kontraproduktiv wirken, statt Verbesserungen voranbringen.

Gute, regelmäßige Evaluation ist zeit- und geldaufwenig. Dies dürfte auch der häufigste Grund dafür sein, dass viel Lehrende, die sich eine zuverlässige und valide Wirkungsrückmeldung ihrer Lehre wünschen, es damit noch nicht versucht haben, oder es wieder aufgegeben haben, nachdem sie es versuchten. Allein die Erhebung der dafür notwendigen Daten bei den Studierenden kostet einige Zeit. Noch mehr Zeit und Geld kostet die Übertragung der Daten in eine Computerdatei, um sie (wenn man die dafür notwendige Expertise hat) mit einem statistischen Programm zu analysieren. Lässt man die Daten durch Drittanbieter analysieren, ist das Ganze für die meisten Lehrenden schnell unbezahlbar.

Ich habe daher vor einiger Zeit damit angefangen, die Durchführung der wissenschaftlichen Evaluation meiner Kurse mit Hilfe des selbst programmierten Internetprogramms ITSE durchzuführen. Die Finanzierung von ITSE erfolgte anfangs aus Mitteln des Ausschusses für Lehre und Weiterbildung der Universität Konstanz, großenteils aber aus Eigenmitteln. Im Sommer 2004 habe ich mehrere Kollegen für eine Erprobung von ITSE gewinnen können. An der Erprobung nahmen 12 Kurse mit insgesamt über 300 Teilnehmern und sechs Dozenten teil. Der Bericht über diese Erprobung kann hier herunter geladen werden (Kurzbericht). Unten wird über eine umfangreiche Serie von experimentelle Interventionsstudien berichtet ... mehr.

Vorteile auf einen Blick

|

|

Lehrende wollen eine gute Lehre machen, bei der die Studierenden möglichst viel lernen, das Gelernte verstehen, das Verstandene anwenden und mit Anwendungen verantwortungsvoll umgehen lernen. Selbstevaluation ist dabei ein sehr wichtiges und effektives (wenn auch immer begrenztes) Hilfsmittel, um fest zu stellen, ob diese Ziele erreicht werden.

Mit dem Begriff Selbstevaluation ist gemeint, dass bei der Evaluation die Kontrolle über die Ziele, Durchführung und Auswertung der Evaluation ganz und gar bei dem Lehrenden selbst liegen. Während "Fremd-Evaluation" meist dazu dient, Personen (hier: Lehrende) zu evaluieren und in eine Rangreihe zu bringen, und sie entsprechend ihren Rangplätzen zu belohnen oder zu bestrafen, geht es bei der Selbstevaluation darum, Lehrmethoden und Lehrinhalte hinsichtlich ihrer Wirksamkeit zu bewerten und dazu beizutragen, die Lehre zu verbessern. Während Fremdevaluation in erster Linie auf Selektion zielt, zielt Selbstevaluation (bzw. Methodenevaluation) auf Lernen und Entwicklung.

Selbstevaluation könnte daher auch "Methoden-Evaluation" genannt werden. Lehrende führen diese Evaluation durch, um sich zu vergewissern, ob die Art wie sie lehren, also ihre Methoden und didaktischen Ansätze, ihre selbst gesteckten Ziele erreichen lassen, bzw. ob neue Methoden und Ansätze zu der erhofften Verbesserung führen.

Selbstevaluation schließt nicht aus, dass die Studierenden befragt und externe Experten zu Rate gezogen werden. Im Gegenteil, beides sind wichtige Kernelemente der Selbstevaluation. Auch ist die Selbstevaluation offen und kann öffentlich betrieben werden, um das allgemein verfügbare Wissen um effektive Lehrmethoden zu mehren. Bei ausreichender Datengrundlage können so "Rankings" von effektiven Lehrmethoden erstellt werden, die dem einzelnen Lehrenden helfen, die eigene Lehre kontinuierlich zu verbessern.

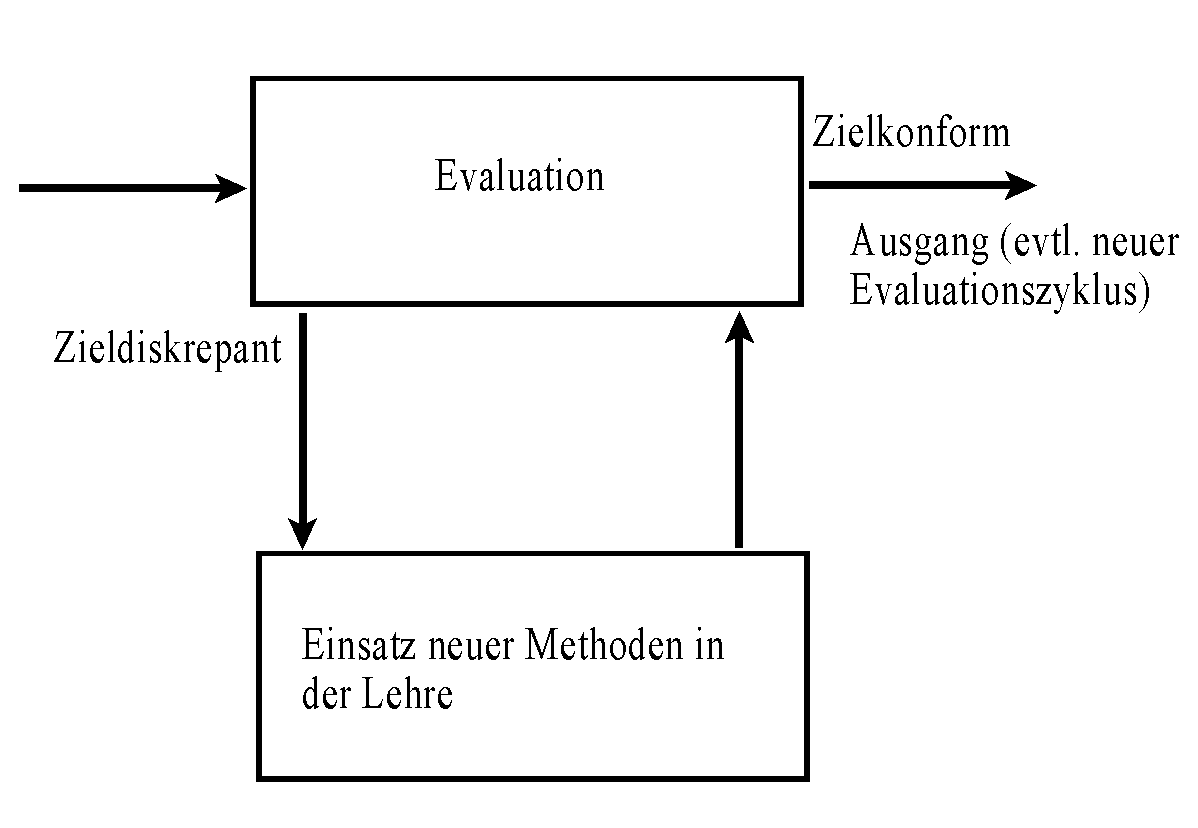

Selbstevaluation stellt also einen Rückkoppelungsprozess im Rahmen einer Qualitätsentwicklung dar, die auf der Grundlage bestimmter Zielsetzungen eine Verbesserungen der Effizienz und Effektivität der Lehre bezüglich bestimmter Aspekte und in bestimmten Kursen intendiert.

|

Ein Beitrag zur Verbesserung der Lehre

Das Wissen, ob die Bemühungen um gute Lehre etwas bewirken, hat vor allem für Motivation des Lehrenden große Bedeutung. Hat sich die Mühe gelohnt? Sind wir auf dem richtigen Weg oder sollten wir es zukünftig anders versuchen? Oft reicht es uns schon, wenn die Kursteilnehmer aufmerksam sind und am Ende zufrieden wirken. Aber manchmal möchten wir auch gern wissen, ob die Studierenden wirklich etwas gelernt haben. Zu leicht können wir uns selbst täuschen: Die Studierenden waren aufmerksam und zufrieden -- und haben vielleicht dennoch wenig von dem verstanden, was wir ihnen vermitteln wollten. Vielleicht sind wir auch sehr unterhaltsam aber wenig effektiv in der Wissensvermittlung gewesen.

Als Hochschullehrer müssen wir uns meist auf unseren "Glauben" verlassen, wenn wir wissen möchten, ob und was wir mit unserer Lehre den Teilnehmern wirklich vermitteln. Von einigen wenigen Teilnehmern können wir unmittelbare Rückmeldung bekommen. Wenn wir wissen wollen, ob alle oder nur ein Teil der Teilnehmer etwas mitnehmen und bei wie vielen unsere Lehre nachhaltige Lernprozesse ausgelöst hat, sind wir jedoch auf systematische Evaluation angewiesen.

Wie wir oben gesehen haben, hilft Evaluation aber nur dann die Lehre zu verbessern, wenn sie ein paar wichtige Kriterien erfüllt:

-

Klare Ziele: Sie muss in einen Prozess der Qualitätsentwicklung eingebettet sein, in dem klare Ziele definiert sind.

-

Zielvalidität: Die Erhebungsinstrumente und das Erhebungsdesign müssen genau auf die Ziele der Qualitätsentwicklung und Evaluation abgestimmt sein.

-

Programmevaluation: Sie sollte sich immer auf Maßnahmen und Methoden richten, aber nicht auf Menschen oder Gruppen (sie kann aus "Selbstevaluation" wie auch als "Fremd-Evaluation" bestehen , siehe oben) und sie sollte Schutz vor Schuldzuweisungen und Sanktionen (auch in der anscheinend "milden" Form des Rankings) bieten. Sonst ist damit zu rechnen, dass die Evaluation "unscharf" wird (zum "Unschärfeprinzip" und Campbells Gesetz in der Bildungsforschung siehe Amrein und Berliner, 2002; Sacks, 2000).

-

Intrinsische Motivation: Sie muss extrinsische Gratifikationen vermeiden; die "Belohnung" sollte allein in der Verbesserung der Lehrqualität und der Lernergebnisse liegen bzw. in der Befriedigung, die man daraus zieht, dass man seine Arbeit gut macht (siehe u.a. Deci et al., 1999; Deming, 1994; Kohn, 1999; McKeachie, 1997).

-

Input-Output-Vergleich: Evaluation sollte so angelegt sein, dass eine möglichst eindeutige Zuschreibung von Ursache und Wirkung möglich ist, weil sonst keine eindeutigen Handlungsempfehlungen aus ihr abgeleitet werden können. Dazu gehört, dass sowohl Output als auch Input untersucht werden müssen. Der ausschließliche Fokus auf einer Seite ist ungenügend.

-

Effizienz: Evaluation sollte auch unter Fragen der Effizienz betrachtet werden. Oft hat sie die größte Wirkung bei geringstem Mitteleinsatz, wenn sie "top-down" statt "bottom-up" geschieht, also zuerst nach Unzulänglichkeiten und Verbesserungsmöglichkeiten an der Spitze einer Machthierarchie sucht, statt an der Basis. Man sollte also zunächst jene Ursachen evaluieren, die man selbst unter Kontrolle hat und relativ leicht verändern kann, bevor man auf Ursachen fokussiert, die nur mit großem Aufwand zu beeinflussen sind.

- Transparenz: Die Anlage, Durchführung und Auswertung der Evaluation muss möglichst transparent für die Adressaten erfolgen.

- Meta-Evaluation: Gute Evaluation muss immer auch selbst evaluiert werden!

Evaluation, die gegen eine oder alle diese Kriterien für gute Evaluation verstößt, wird im besten Fall wirkungslos bleiben, im schlimmsten Fall kontraproduktiv sein.

Wirkungslose und schlechte Evaluation erkennt man daran,

-

dass die Zielsetzungen und Kriterien kaum oder gar nicht expliziert werden,

-

dass nur eine einmalige Erhebung erfolgt,

-

dass die vorgeblichen Ziele sich in den Erhebungsinstrumenten kaum wiederfinden lassen bzw. die Zielvalidität der eingesetzten Erhebungsinstrumente nicht bekannt oder gering ist, und

-

dass die Ergebnisse der Evaluation mit unangemessenen Sanktionen oder Belohnungen (Gatifikationen, Mittelentzug, Ranking etc.) verbunden sind, die das Augenmerk der Beteiligten mehr auf diese Sanktionen als auf das eigentliche Ziel der Qualifikationsverbesserung lenken.

Der Bildungsforscher Mark Smylie (1994) fasst den Stand der Forschung hierzu so zusammen:

"... effects of evaluation systems may be short lived, particularly if teachers do not agree with the conception of teaching they embody or the direction in which they attempt to influence teachers' behavior (Darling-Hammond & Sclan, 1992). The changes teachers make in their practice may become 'calculative' and not sustained. ... Firestone and Pennell (1992) warn that evaluation systems with exceptionally tight, highly specified criteria may infringe on teachers' sense of autonomy by restricting choices about objectives and methods. ... this effect may diminish the motivational potential of work redesign and, in turn, thwart efforts to improve classroom instruction." (S. 145-146)

Hochschulforscher fassen umfangreiche Studien zur Leistungsbewertung und Evaluation so zusammen:

"We believe grades and grading practice should be in the service of learning and teaching, not ranking. [...] Tests and grades as we now know them do not serve the purpose of promoting students learning very well." (Milton et al., 1986, S. 203 u 207)

Der Ökonom W. Edward Deming sekundiert ihnen dabei:

"The ranking of people indicates abdictation of management. The aim of anybody, under the merit system, is to please the boss. The result is destruction of morale. Quality suffers." (Deming, 1994, S. 27). "What is the effect of grading and ranking? Answer: humiliation of those that do not receive top grades or top rank. The effect of humiliation is demoralization of the individual. Even he that receives top grades or top rank is demoralized." (S. 148)

Bezogen auf die Hochschullehre folgert der Züricher Wirtschaftswissenschaftler Bruno Frey:

"Leistungsorientierte Besoldung [verdrängt] die intrinsische Motivation. ... Eine hohe intrinsische Motivation ist für Hochschullehrer unentbehrlich." (Frey, 2003, S. 543)

Lehre sollte schrittweise verbessert werden, indem man sich bestimmte Probleme oder Defizite vornimmt und diese zu verbessern versucht. Oft empfiehlt es sich auch, diese Verbesserungen zunächst in einer bestimmten Lehrveranstaltung vorzunehmen, und sie dann schrittweise an andere Kurstypen anzupassen. Daher muss jede Evaluation auch den spezifischen Erfordernissen einer Qualitätsentwicklung angepasst sein. Eine "Einheits-Evaluation", die für jeden Kurs und für alle Lehrenden passt, kann es nicht geben.

Zum Thema gute Evaluationsdesigns siehe auch mein ausführliches Skript (in Bearbeitung).

Unser Angebot: Unterstützung der Selbstevaluation der Lehre

Evaluation ist, wenn sie richtig durchgeführt wird, in der Regel mit einigem Aufwand verbunden, der von vielen nicht geleistet werden kann. Es ist nicht ganz einfach festzustellen, ob die real bestehende Lehrpraxis das bewirkt, was man sich davon erhofft, bzw. ob neue Lehrmethoden die erhofften Veränderungen bewirken.

Mit diesem Projekt soll daher auf dreifache Weise Hilfestellung bei der Durchführung einer Evaluation eigener Lehrveranstaltungen gegeben werden:

-

Coaching bei der Konkretisierung der Evaluationsziele und der Umsetzung dieser Ziele in ein Evaluationsdesign und zielvalide Erhebungsinstrumente (Beispiel).

-

Unterstützung bei der Durchführung der Erhebungen bei den Studierenden und technischer Support via Internet bei der Analyse der gewonnenen Daten, so dass die Kosten für die Datenerfassung und -analyse gering sind.

-

Beratung bei der Interpretation und Umsetzung der Ergebnisse: Ist eine Änderungen der bisherigen Praxis notwendig? Wenn ja: was könnte als nächster Schritt versucht werden? Wie könnte eine neuerliche Evaluation aussehen?

Diese Selbstevaluation wird in der Eigenverantwortung des Lehrenden durchgeführt und strikt vertraulich behandelt. Die Daten sind für niemand anderen zugänglich. Der Leiter und alle Mitarbeiter dieses Projekts verpflichten sich, soweit sie überhaupt Einsicht in die Daten haben können, zur Einhaltung strikter Vertraulichkeit. Nach Abschluss der Entwicklungsarbeiten sollen sämtliche Daten und auch die eingesetzten Programme dem Lehrenden überlassen werden, dem dadurch die Option gegeben ist, seine Evaluation auf einem eigenen Web-Server durchzuführen und an jeden beliebigen neuen Arbeitsplatz mitzunehmen. Alle eingesetzte Software ist 'open source', frei nutzbar und sowohl unter Windows wie unter Linux einsetzbar. Der Autor dieses Projekts macht keine Lizenzansprüche geltend.

Jeder Lehrende, der den Service dieses Projekts nutzt, verpflichtet sich seinerseits, die erhobenen Daten anonymisiert für weitere, Kurs- und Dozenten-übergreifende Analysen zur Verfügung zu stellen, um so zu einer Wissensdatenbank beizutragen, in der Erfahrungen mit unterschiedlichen didaktischen Methoden und Maßnahmen gesammelt werden sollen. Die Auswertung dieser Daten wird sich strikt auf den Vergleich von Methoden und Maßnahmen konzentrieren und keine Personen vergleichen. Die Selbstevaluation der Lehre durch Einzelne trägt dann auch dazu bei, das hochschuldidaktische Wissen aller Lehrenden zu erweitern.

Das Grundmodell der wissenschaftlichen Selbstevaluation

In einem ersten Schritt wird ein Grundmodell der wissenschaftlichen Selbstevaluation angeboten, dass für jeden einige individuelle Ergänzungsmöglichkeiten bietet. Die Hauptelemente sind eine Basiserhebung ("input") und eine Schlusserhebung ("output"). Unser konkretes Angebot umfasst folgende Teile:

-

Beratung bei der Konkretisierung der Zielsetzung der Evaluation. Auf Wunsch werden Tips zur Anreicherung des eigenen didaktischen Methodenrepertoirs und Hilfestellung bei der Umsetzung gegeben (siehe meine Hochschuldidaktik-Seite: https://moralcompetence.net/hodi/index.htm).

-

Zwei Erhebungen, eine ganz am Anfang und eine am Ende des Semesters.

-

Optionen für später:

- Eine dritte Erhebung (Zwischenerhebung) mitten im Semester.

- Erhebungen bei Vergleichsgruppen, um eine genauere Schätzung des Lehreffekts zu erhalten.

-

-

Zwei über das Internet dargebotene Befragungsinstrumente, die gemeinsame Teile enthalten, um Veränderungen feststellen zu können, und erhebungsspezifische Teile, um Voraussetzungen und Ergebnisse des Lehr-Lernprozesses ermitteln zu können. Der folgende Überblick stellt die Inhalte beispielhaft dar:

- Basiserhebung (base line assessment, pretest)

Spezifische Fragen: Semesterzahl; angestrebter Studienabschluss; Grund für Kursteilnahme; Erwartungen an den Kurs; Vorkenntnisse etc.

Gemeinsame Fragen/Tests: Wissens- und Kompetenztests mit Bezug auf fachliche und überfachliche Lernziele des Kurses.

- Schlusserhebung (final assessment; posttest)

Spezifische Fragen: Umfang der Mitarbeit im Kurs; Fehlzeiten; Menge des Gelernten im Vergleich mit den eigenen Erwartungen, mit dem Lernergebnis sonst in anderen Kursen und mit den vermuteten beruflichen Anforderungen.

Gemeinsame Fragen/Tests: Dieselben Wissens- und Kompetenztests wie bei der Basiserhebung.

Als Ausgangsmaterial wird das Erhebungsinstrument angeboten, das der Projektleiter seit mehreren Jahren in seinen Kursen eingesetzt und erprobt hat. Jeder Lehrende ist natürlich frei, seine Selbstevaluation seinen spezifischen Erfordernissen anzupassen und eigene Instrumente zu entwickeln.

-

Beratung bei der Interpretation der Daten und Umsetzung der Ergebnisse.

Das Ziel der Evaluation muss anfangs nicht hoch gesteckt sein. Es kann darin bestehen zu fragen, was mit der Veranstaltung, wie sie bisher durchgeführt wurde, erreicht wird. Mit einer solchen Fragestellung kann die "Baseline" für zukünftige Fortschritte ermittelt werden.

Lehrende aller Fachrichtungen sind eingeladen, an dem Projekt teilzunehmen.

Ich bin "von Haus aus" Bildungsforscher (von 1973 bis 1985 als Mitglied des SFB 23 Bildungsforschung) und Lehr-Lernpsychologe und mit der einschlägigen Literatur seit langem vertraut. Daher habe ich schon früh mit der Selbstevaluation meiner Lehre begonnen, und zwar auf der Grundlage von wissenschaftlichen Mindeststandards, wie ich sie oben beschrieben habe.

Natürlich verlasse ich mich nie allein auf solche Befragungen, sondern hole im Kurs laufend Rückmeldung ein, ob die dort stattfindenden multiplen Lehr- und Lernprozesse einigermaßen synchron verlaufen.

Die Selbstevaluation meiner Veranstaltungen ergab zusammen mit neueren lernpsychologischen Erkenntnissen wichtige Hinweise, wie ich meine Kurse didaktisch effektiver machen konnte. Schon nach kurzer Zeit ist es dadurch in allen Veranstaltungen gelungen, eine höhere Aufmerksamkeitsrate und Mitarbeit zu erreichen. Nach einigen Semestern konnten auch die Lerneffekte meiner Veranstaltung bezüglich wichtiger Lernziele deutlich gesteigert werden. Beispielsweise lies sich so die Urteils- und Diskursfähigkeit der Studierenden, ein wichtiges überfachliches Lernziel, stark verbessern. Der Zugewinn in einem Kurs ist heute deutlich höhrer als er noch vor einigen Semestern war.

Als Beispiel für einen Fragebogen-Satz (Basis- und Schlussbefragung) zur Selbstevaluation finden Sie im Internet die Fragebogen, die ich in meinen Lehrveranstaltungen verwendet habe:

Der Beispielfragebogen für die beiden Evaluationserhebungen beinhaltet als gemeinsamen Teil einen Test zur moralischen Urteils- und Diskursfähigkeit, einem zentralen überfachlichen Lernziel universitärer Bildung. Lehre und Studium sollen, wie das Hochschulrahmengesetz von 1999 feststellt, "den Studenten auf ein berufliches Tätigkeitsfeld vorbereiten und ihm die dafür erforderlichen fachlichen Kenntnisse, Fähigkeiten und Methoden dem jeweiligen Studiengang entsprechend so vermitteln, daß er zu wissenschaftlicher oder künstlerischer Arbeit und zu verantwortlichem Handeln in einem freiheitlichen, demokratischen und sozialen Rechtsstaat befähigt wird." (HRG, § 7; siehe auch Bargel & Framhein, 1976; Bargel et al., 1982). Aber tun sie das auch?

Der "Moralisches Urteil-Test" (MUT) wurde 1976 in Konstanz im Sonderforschungsbereich 23 "Bildungsforschung" entwickelt (Lind, 1978; 2008) und in einer international vergleichenden Längsschnittstudie zur Analyse der Wirksamkeit fünf nationaler Bildungssysteme eingesetzt (siehe Lind, 1986). Er wurde inzwischen in dreißig Sprachen übersetzt und weltweit bei über 250.000 Studierenden und SchülerInnen eingesetzt, in Deutschland, Kolumbien und Mexiko als zentrales Maß für die Wirksamkeit des Bildungssystems. ... mehr

Der MUT enthält zwei Dilemmageschichten mit Pro- und Contra-Argumenten, die nach ihrer Akzeptabilität zu beurteilen sind. Anhand der Urteilsmuster kann festgestellt werden, in welchem Maß die Studierenden sich bei ihren Urteilen konsequent an (eigenen) moralischen Maßstäben orientieren statt daran, ob die zu beurteilenden Argumente für oder gegen ihre Haltung in einer Kontroverse spricht. Der C-Index für moralische Urteilsfähigkeit lässt sich nicht simulieren, ist aber sensitiv für die Wirkung begünstigender Lernumwelten (Lind, 2002). Unter günstigen Voraussetzungen können in einer einsemestrigen Lehrveranstaltung relative Effektstärken von r = .60 und höher erreicht werden (auf einer Skala von 0.00 bis 1.00). Verschiedene absolute Effektstärken sind unten in der Graphik abgetragen (geschätzt auf Grund zahlreicher Studien bzw. direkte Ergebnisse aus Studien mit dem MUT; maximal möglicher Zuwachs = 100 auf einer skala von 0 bis 100; zu den Schätzungen siehe Lind, 2002).

Aufgrund von ITSE-Anwendungen bei mehr als 40 Kursen (mit insgesamt über 3000 Studierenden) mittels experimentellemVorher-Nachher-Design hat Lind (2009) gezeigt, dass Seminare hoch effektiv gestaltet werden können, klassische Vorlesungen sich jedoch weitgehend immun gegen Versuchen der Effektvitätssteigerung erwiesen, wenn es darum geht, Urteils- und Diskursfähigkeit zu fördern.

Literatur

Amrein, A. & Berliner, D. (2002). High-stakes testing, uncertainty, and student learning. Education Policy Analysis Archives, 10 (18), March 28, 2002. Bezogen (Juli 2002) von: http://epaa.asu.edu/epaa/v10n18/

Bargel, T. & Framhein, G. (1976). Zur Diskussion von Bildungszielen und zur Leistungsmessung im Hochschulbereich. In: W. Zapf, Hg.., Gesellschaftspolitische Zielsysteme. Soziale Indikatoren IV. S. 126-161 Frankfurt Campus.

Bargel, T., Markiewicz, W. & Peisert, H. (1982). University Graduates: Study experience and social role - Empirical findings of a comparative study in five uropean countries. In: M. Niessen & J. Peschar, Hg., Comparative research on education. S. 55-78 Oxford Pergamon.

Deci, E.L., Koestner, R. & Ryan, R.M. (1999): Examining the effects of extrinsic rewards on intrinsic motivation. Psychological Bulletin, 125, 627-668.

Deming, W. E. (1994). The new economics for industry, government, education. Second edition. Cambridge MA Massachusetts Institute of Technology.

Frey, Bruno S. (2003). Mehr Leistung durch mehr Geld? Forschung & Lehre 10/2003, 543.

Frey, B.S. & Osterloh, M. (2008). Pay for performance -- immer empfehlenswert? Zeitschrift für Führung + Organisation 69. Jg. (2000), Heft 2, 64-69.

Kohn, A. (1999). Punished by Rewards. The Trouble with Gold Stars, Incentive Plans, A's, Praise, and other Bribes. Boston: Houghton Mifflin. (Second Edition).

McKeachie, W.J. (1997). Student ratings. The validity of use. American Psychologist, 52, 1218-1225.

Lind, G. (1978). Wie misst man moralisches Urteil? Probleme und alternative Möglichkeiten der Messung eines komplexen Konstrukts. [How does one measure moral judgment? Problems and alternative possibilities of measuring a complex construct]. In G. Portele, Ed., Sozialisation und Moral. [Socialization and Morality]. Weinheim: Beltz, pp. 171-201.

Lind, G. (2002). Ist Moral lehrbar? Ergebnisse der modernen moralpsychologischen Forschung. [Can morality be taught? Research findings from modern Moral Psychology]. Second Edition. Berlin: Logos-Verlag.

Lind, G. (2008). The meaning and measurement of moral judgment competence revisited - A dual-aspect model. In: D. Fasko & W. Willis, Eds., Contemporary Philosophical and Psychological Perspectives on Moral Development and Education, pp. 185 - 220. Cresskill. NJ: Hampton Press.

Lind, G. (2009). Favorable learning environments for moral development – A multiple intervention study with nearly 3.000 students in a higher education context. Paper presented at the annual meeting of AERA in San Diego, April 13 - 17, 2009. .. more

Lind, G. (2009b). Amerika als Vorbild? Erwünschte und unerwünschte Folgen aus Evaluationen. [America as role model? Desired and undesired consequences of evaluation.] In: T. Bohl & H. Kiper., eds., Lernen aus Evaluationsergebnissen – Verbesserungen planen und implementieren, pp. 61-79. Bad Heilbrunn: Julius Klinkhardt. Vollständige Fassung mit den nicht publizierten Kapiteln über „Bildung und Evaluation in den USA“ und „Programmevaluation": ![]()

Osterloh, M. & Weibel, A. (2006). Investition Vertrauen. Prozesse der Vertrauensentwicklung in Organisationen. Wiesbaden: Gabler.

Sacks, P. (2000). Standardized minds. The high price of America's testing culture and what we can do to change it. Cambridge, MA: Perseus Publishing.

Smylie, M.A. (1994). Redesigning teachers' work: Connections to the classroom. In: L. Darling-Hammond, Hg., Review of Education, 20, 129-177 Washington, DC AERA